Nuevo método de entrenamiento mejora la capacidad de IA para localizar objetos personalizados

Investigadores del MIT y del MIT-IBM Watson AI Lab han desarrollado una técnica innovadora que permite a los modelos de inteligencia artificial visual-lingüística identificar y rastrear objetos específicos con mayor precisión. Este avance aborda una limitación fundamental en los sistemas actuales de IA generativa, que suelen destacar en el reconocimiento de categorías generales pero fallan al localizar instancias particulares.

El problema de la localización personalizada

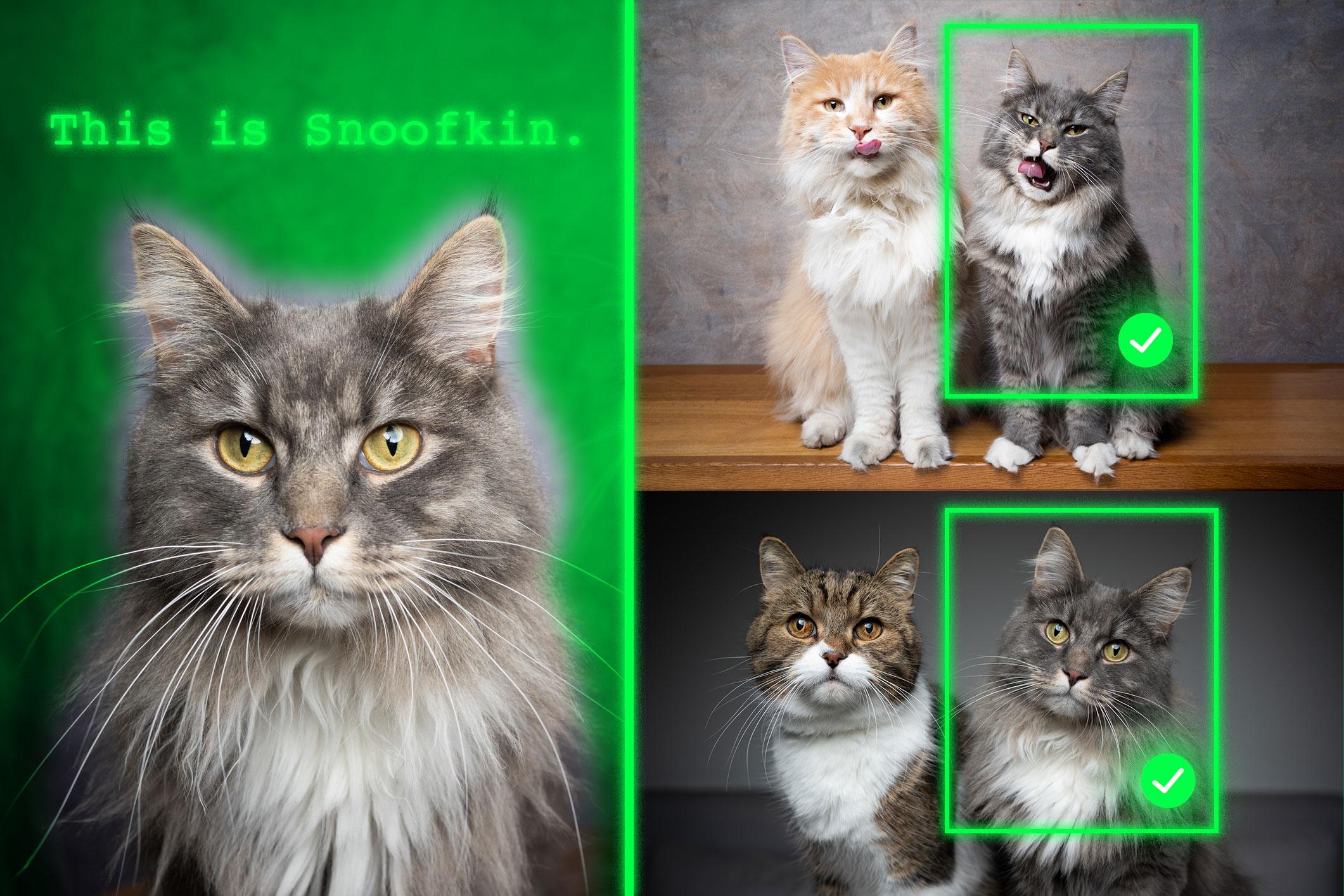

Los modelos visual-lingüísticos como GPT-5 demuestran capacidades excepcionales para identificar objetos genéricos -como "perro" o "coche"-, pero enfrentan dificultades significativas cuando deben localizar elementos específicos dentro de esas categorías. Este desafío se hace evidente en escenarios prácticos donde se requiere el seguimiento continuo de objetos particulares, como mascotas individuales o pertenencias personales.

"La comunidad investigadora aún no ha encontrado una respuesta definitiva a este problema particular. El cuello de botella podría surgir del hecho de que cierta información visual se pierde en el proceso de fusionar los dos componentes, pero simplemente no lo sabemos", explica Jehanzeb Mirza, investigador postdoctoral del MIT y autor principal del trabajo.

Metodología innovadora basada en contexto

El equipo de investigación abordó esta limitación mediante el desarrollo de un nuevo enfoque de entrenamiento que utiliza datos de seguimiento por video cuidadosamente preparados.

La estructura del dataset asegura que cada entrada contenga múltiples imágenes del mismo objeto en diferentes contextos, acompañadas de preguntas y respuestas sobre su ubicación. "Al usar múltiples imágenes del mismo objeto en diferentes contextos, incentivamos al modelo a localizar consistentemente ese objeto de interés centrándose en el contexto", detalla Mirza.

Superando las trampas del aprendizaje automático

Durante la investigación, los científicos descubrieron que los modelos tendían a "hacer trampa" utilizando conocimiento previo en lugar de inferir basándose en el contexto. Para contrarrestar este comportamiento, implementaron el uso de seudónimos en lugar de nombres reales de categorías de objetos. Esta estrategia obligó a los modelos a prestar atención a las características contextuales específicas en lugar de recurrir a asociaciones preexistentes.

"Nos tomó un tiempo descubrir cómo evitar que el modelo hiciera trampa. Pero cambiamos las reglas del juego para el modelo. El modelo no sabe que 'Charlie' puede ser un tigre, por lo que se ve forzado a mirar el contexto", comenta Mirza.

Resultados significativos y aplicaciones potenciales

La implementación de esta metodología produjo mejoras sustanciales en el rendimiento. El ajuste fino de modelos con el nuevo dataset mejoró la precisión en la localización personalizada en aproximadamente un 12% en promedio. Cuando se incluyeron los seudónimos, las ganancias de rendimiento alcanzaron el 21%. Además, los investigadores observaron que las mejoras se amplifican con el aumento del tamaño del modelo.

Las aplicaciones potenciales de esta tecnología son extensas. Podría utilizarse en sistemas de seguimiento temporal de objetos específicos, como el monitoreo de mochilas infantiles o la localización de especies animales en estudios ecológicos. También podría impulsar el desarrollo de tecnologías asistivas para usuarios con discapacidad visual, facilitando la identificación de objetos en entornos cotidianos.

Próximos pasos en la investigación

El equipo planea investigar las razones subyacentes por las cuales los modelos visual-lingüísticos no heredan las capacidades de aprendizaje contextual de sus modelos de lenguaje base. También explorarán mecanismos adicionales para mejorar el rendimiento sin necesidad de reentrenar los modelos con nuevos datos.

Saurav Jha, investigador postdoctoral del Mila-Quebec Artificial Intelligence Institute que no participó en el trabajo, señala: "Esta investigación replantea la localización personalizada de objetos con pocos ejemplos -adaptándose sobre la marcha al mismo objeto a través de nuevas escenas- como un problema de ajuste por instrucción y utiliza secuencias de seguimiento por video para enseñar a los modelos visual-lingüísticos a localizar basándose en contexto visual en lugar de conocimientos previos de clase".

Colaboración interinstitucional

El trabajo contó con la colaboración de investigadores del MIT, Weizmann Institute of Science, IBM Research, Johannes Kepler University, Tuebingen AI Center, Tel Aviv University y otros centros académicos. La investigación fue financiada parcialmente por el MIT-IBM Watson AI Lab y será presentada en la International Conference on Computer Vision.